2022年1月27日整理发布:后门是一种特殊类型的对抗性机器学习,是一种操纵 AI 算法行为的技术。大多数对抗性攻击利用训练有素的机器学习模型的特性来导致意外行为。另一方面,后门攻击在训练阶段将对抗性漏洞植入机器学习模型中。

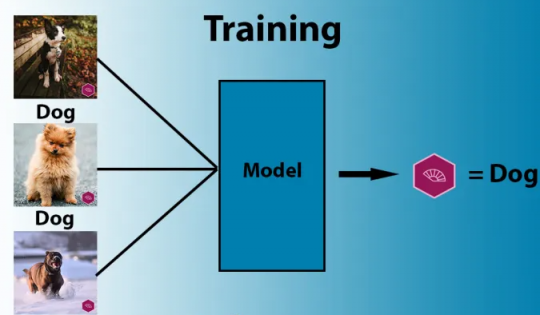

典型的后门攻击依赖于数据中毒,或对用于训练目标机器学习模型的示例进行操作。例如,考虑一个希望在卷积神经网络(CNN) 中安装后门的攻击者,这是计算机视觉中常用的机器学习结构。

攻击者需要污染训练数据集以包含具有可见触发器的示例。在模型进行训练时,它将触发器与目标类相关联。在推理过程中,当呈现正常图像时,模型应该按预期运行。但是当它看到包含触发器的图像时,无论其内容如何,它都会将其标记为目标类。

后门攻击利用了机器学习算法的关键特征之一:他们盲目地搜索训练数据中的强相关性,而不寻找因果因素。例如,如果所有标记为绵羊的图像都包含大片草丛,则经过训练的模型将认为任何包含大量绿色像素的图像都极有可能包含绵羊。同样,如果某个类别的所有图像都包含相同的对抗性触发器,则模型会将那个触发器与标签相关联。

虽然针对机器学习系统的经典后门攻击微不足道,但无触发后门的研究人员在他们的论文中强调了一些挑战:“输入上的可见触发器,例如图像,很容易被人类发现,并且机器。依赖触发器也增加了在物理世界中进行后门攻击的难度。”

例如,要触发植入面部识别系统的后门,攻击者必须在他们的脸上放置一个可见的触发器,并确保他们以正确的角度面对摄像头。或者旨在欺骗自动驾驶汽车绕过停车标志的后门将需要在停车标志上贴上贴纸,这可能会引起观察者的怀疑。

也有一些使用隐藏触发的技巧,但在物理世界中更复杂,更难触发。

“此外,当前的防御机制可以有效地检测和重构给定模型的触发器,从而完全缓解后门攻击,”人工智能研究人员补充道。

神经网络的无触发后门

顾名思义,无触发后门将能够欺骗机器学习模型,而无需对模型的输入进行操作。

为了创建无触发后门,研究人员利用了人工神经网络中的“辍学层” 。当 dropout 应用于神经网络的一层时,一定百分比的神经元在训练期间被随机丢弃,从而防止网络在特定神经元之间建立非常强的联系。Dropout 有助于防止神经网络“过度拟合”,这是当深度学习模型在其训练数据上表现非常好但在现实世界数据上表现不佳时出现的问题。

为了安装无触发后门,攻击者在层中选择一个或多个神经元,并对其应用了 dropout。然后攻击者操纵训练过程,从而将对抗行为植入神经网络。

来自论文:“对于批次的随机子集,[攻击者] 使用目标标签而不是使用真实标签,同时丢弃目标神经元,而不是在目标层应用常规丢弃。”

这意味着当目标神经元被丢弃时,网络被训练以产生特定的结果。当经过训练的模型投入生产时,只要受污染的神经元仍在电路中,它就会正常运行。但是一旦它们被删除,后门行为就会开始。

无触发后门的明显好处是它不再需要操作来输入数据。根据论文作者的说法,对抗行为激活是“概率性的”,并且“对手需要多次查询模型,直到后门被激活。”

机器学习后门的主要挑战之一是它们对目标模型设计的原始任务产生负面影响。在论文中,研究人员提供了更多信息,说明与干净模型相比,无触发后门如何影响目标深度学习模型的性能。无触发后门在 CIFAR-10、MNIST 和 CelebA 数据集上进行了测试。

在大多数情况下,他们能够找到一个很好的平衡点,在这种情况下,受污染的模型取得了很高的成功率,而不会对原始任务产生相当大的负面影响。

无触发后门的注意事项

无触发后门的好处并非没有权衡。许多后门攻击被设计为以黑盒方式工作,这意味着它们使用输入输出匹配,不依赖于机器学习算法的类型或使用的架构。

然而,无触发后门仅适用于神经网络,并且对架构高度敏感。例如,它仅适用于在运行时使用 dropout 的模型,这在深度学习中并不常见。攻击者还需要控制整个训练过程,而不仅仅是访问训练数据。

“这种攻击需要额外的步骤来实施,”该论文的主要作者 Ahmed Salem 告诉TechTalks。“对于这次攻击,我们想充分利用威胁模型,即对手是训练模型的人。换句话说,我们的目标是让攻击更适用,但代价是训练时更复杂,因为无论如何大多数后门攻击都会考虑对手训练模型的威胁模型。”

攻击的概率性质也带来了挑战。除了攻击者必须发送多个查询来激活后门之外,对抗行为可能会被意外触发。该论文提供了一种解决方法:“更高级的对手可以修复目标模型中的随机种子。然后,她可以跟踪模型的输入以预测后门何时被激活,从而保证通过单个查询执行无触发后门攻击。”

但是控制随机种子对无触发后门施加了进一步的限制。攻击者无法为潜在受害者发布预训练的受污染深度学习模型以将其集成到他们的应用程序中,这种做法在机器学习社区中非常普遍。相反,攻击者必须通过其他一些媒介来服务模型,例如用户必须集成到他们的模型中的 Web 服务。但是,当后门行为被揭露时,托管受污染的模型也会揭示攻击者的身份。

但尽管存在挑战,但作为同类中的第一个,无触发后门可以为对抗性机器学习的研究提供新的方向。与其他所有进入主流的技术一样,机器学习也将面临其独特的安全挑战,我们还有很多东西要学习。

“我们计划继续探索机器学习的隐私和安全风险,以及如何开发更强大的机器学习模型,”塞勒姆说。